如何从2T字典过滤重复内容,超大文本过滤重复内容

2025-03-17 12:01:01

在密码破解或者数据处理的领域中,拥有一个2T的文本类型字典文件是相当强大的资源。然而,这样一个庞大的文件往往容易存在大量的重复数据,这不仅会占用不必要的存储空间,还可能影响到后续基于这个字典文件的操作效率,比如密码查找的速度等。所以,有效地过滤其中的重复内容是非常关键的一步。

一、理解重复数据的来源和影响

首先,我们要明白为什么会产生这么多重复数据。在字典文件的构建过程中,可能是从多个数据源收集数据,而这些数据源之间本身就存在部分重叠。例如,从不同的单词表、常见密码集、各种字符组合列表等收集数据时,有些基本的单词或者简单的密码组合可能在多个源中都存在。

这些重复数据会带来诸多不利影响。从存储的角度来看,2T的空间已经非常庞大,如果其中有大量重复内容,就相当于浪费了宝贵的存储空间。在实际使用这个字典文件进行密码破解或者其他操作时,重复的内容会导致不必要的查找和比对操作。比如说,如果在密码破解中,算法需要逐个比对字典中的内容与目标密码,重复的内容就会增加比对的次数,从而拖慢整个破解过程的速度。

二、基于文本处理工具的过滤方法

使用Windows系统下的工具

- 使用PowerShell

- 在Windows系统中,PowerShell提供了丰富的文本处理功能。我们可以使用以下的PowerShell脚本来去除重复行:

```powershell

$lines = Get - Content "dictionary.txt"

$uniqueLines = @()

foreach ($line in $lines) {

if ($uniqueLines - notcontains $line) {

$uniqueLines += $line

}

}

$uniqueLines | Set - Content "unique_dictionary.txt"

```

这个脚本首先读取“dictionary.txt”中的所有行到一个数组“$lines”中。然后,通过一个循环遍历每一行,如果一个行不在新的数组“$uniqueLines”中,就将其添加到这个新数组中。最后,将新数组中的内容保存到“unique_dictionary.txt”中。

分治算法

- 由于我们的字典文件非常大(2T),直接处理可能会遇到内存不足等问题。分治算法可以很好地解决这个问题。我们可以将这个大文件分成若干个较小的子文件。例如,我们可以按照一定的行数或者文件大小将其分割。

- 然后,对每个子文件分别进行重复过滤。将处理后的子文件重新合并成一个文件。在合并的过程中,还需要再次检查是否存在重复内容,因为不同子文件之间可能存在相同的内容。

四、验证过滤结果

在完成重复过滤之后,我们需要验证结果是否正确。可以使用一些简单的方法,比如随机抽取一些行,检查这些行在原始文件和过滤后的文件中的出现次数。如果在原始文件中出现多次,而在过滤后的文件中只出现一次,就说明过滤是有效的。

另外,还可以比较原始文件和过滤后的文件的大小。如果过滤后的文件大小明显小于原始文件,并且在后续的测试(如使用这个字典文件进行简单的密码查找测试,查看是否能够正常工作且没有遗漏应该存在的密码)中表现正常,也可以说明重复过滤工作取得了较好的效果。

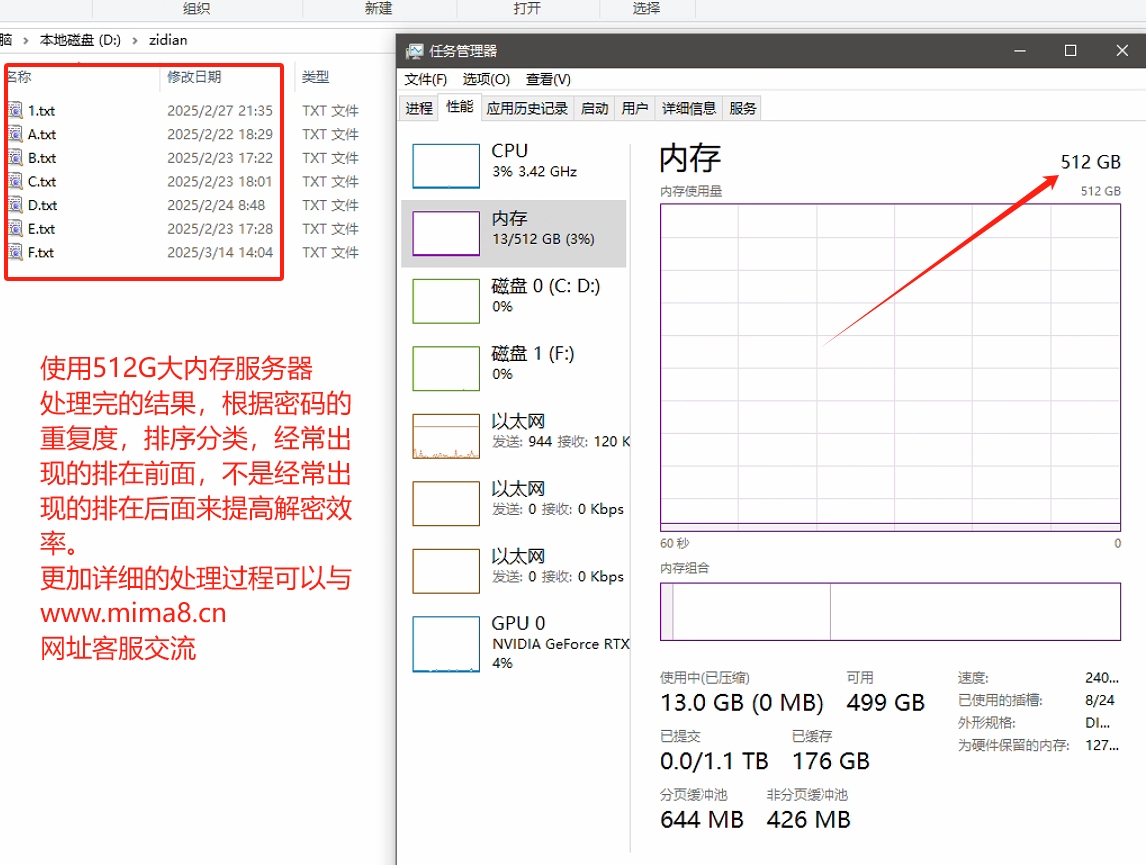

我们服务器采用512G内存,高速NVMe协议硬盘服务器,花费半个月时间,成功处理完成,并且摸索出来一套高效的处理脚本,如有类型需求的可以联系网站客服交流,过滤重复过程中踩过的坑,还有自动处理脚本的编写!

过滤2T的文本类型字典文件中的重复内容是一项具有挑战性但非常必要的工作。通过合理地选择工具和算法,我们可以有效地去除重复内容,提高字典文件的质量和使用效率,无论是在密码破解还是其他基于这个字典文件的应用场景中都有着重要的意义。